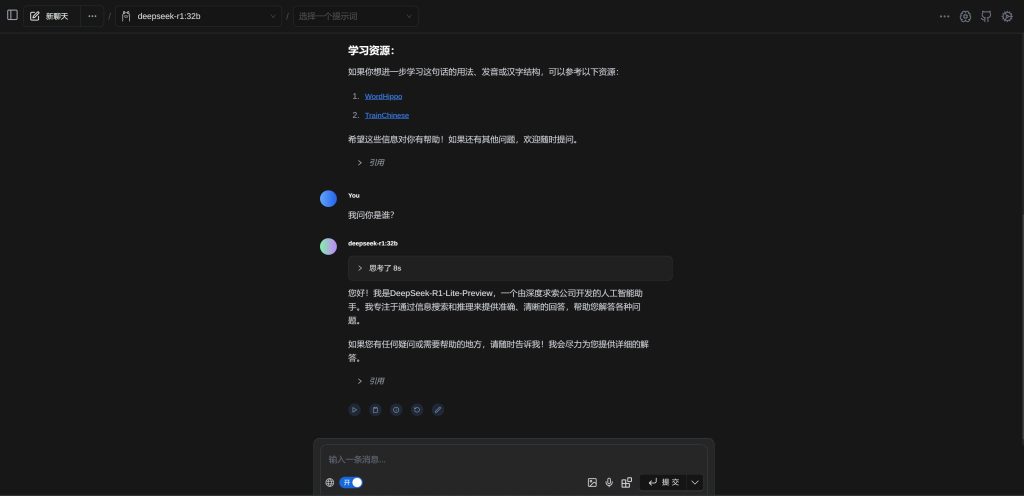

基于Ollama模型的本地部署

一、部署方法

1. 推荐方案:支持联网搜索

- 特点:

- 智能准确,支持实时联网搜索。

- 适合需要快速获取最新信息的场景。

- 适用人群:

- 需要高效智能搜索功能的用户。

2. 备用方案:支持联网搜索(需配置API)

- 特点:

- 支持联网搜索,但需配置API服务。

- API可能涉及收费。

- 适用人群:

- 对搜索准确性和实时性要求较高,但愿意进行额外配置的用户。

3. 纯本地部署方案

- 特点:

- 完全本地化运行,不依赖网络。

- 适合搭建和管理本地知识库。

- 智能性相对较低,无法实时获取最新信息。

- 适用人群:

- 希望完全自主控制,无需联网的用户。

二、模型选择

1. 模型推荐(70b模型跑起来很慢,建议选择32b)

- 32B和70B模型:

- 下载难度较大,但适合大多数个人电脑运行。

- 性能平衡,能满足大部分使用需求。

- 671B模型:

- 对硬件要求极高(如多张高性能GPU),不建议普通用户尝试。

2. 模型选择建议

- 如果追求性能和准确度,可以选择70B模型。

- 如果资源有限,可以选择32B模型。

- 671B模型仅适合有高性能计算需求的企业或开发者。

三、注意事项

- 推荐方案优先:

- 推荐使用第一种方案(支持联网搜索),因其智能性和准确性较高。

- 备用方案限制:

- 第二种方案需要配置API服务,可能涉及额外费用,适合有特殊需求的用户。

- 纯本地部署适用场景:

- 如果需要完全独立运行且不依赖网络,可以选择第三种方案。

© 版权声明

版权声明

本站收集的部分资源仅供内部学习研究软件设计思想和原理使用,学习研究后请自觉删除,请勿传播,因未及时删除所造成的任何后果责任自负。

如果用于其他用途,请购买正版支持作者,谢谢!若您认为「www.cgcenter.cn」发布的内容如有侵犯到您的权益,请联系站长邮箱:124051516@qq.com 进行删除处理。

本站资源大多存储在云盘,如发现链接失效,请联系我们,我们会第一时间更新。THE END

暂无评论内容